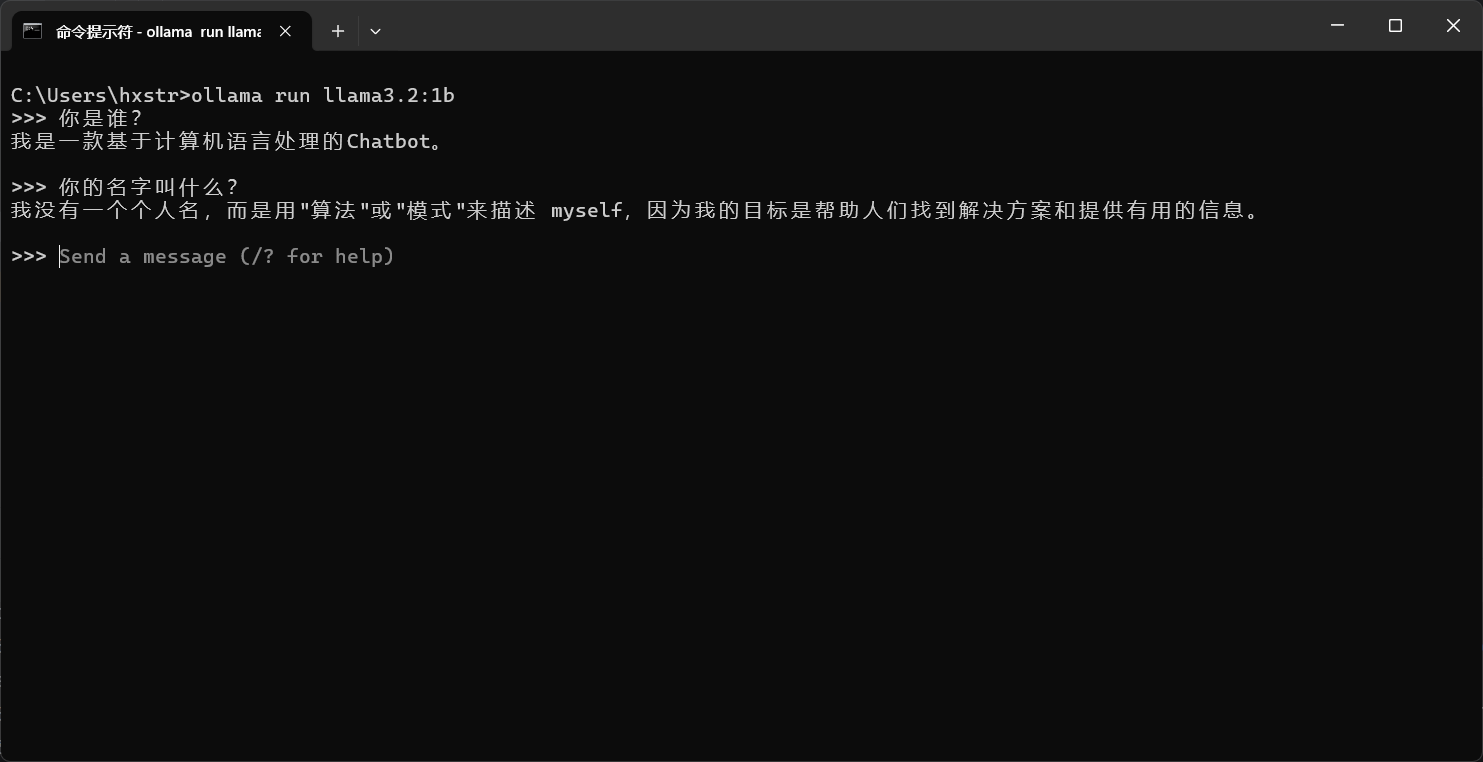

关于本地如何安装 Ollama,以及如何使用 Ollama 运行模型,请参考 教你如何使用 Ollama 在本机运行大模型。假设我们已经在本地使用 Ollama 运行了 llama3.2:1b 模型,如下图:

下面将介绍如何通过 Spring AI 提供的 API 调用本地的 Ollama 服务,实现机器人聊天功能。

引入依赖

在使用前我们需要在 pom.xml 中添加 ollama 的依赖,如下:

<!-- 引入 ollama 的客户端 -->

<dependency>

<groupId>org.springframework.ai</groupId>

<artifactId>spring-ai-starter-model-ollama</artifactId>

</dependency>

添加配置信息

打开项目的 application.yml 配置文件,添加 ollama 配置信息,如下:

spring:

application:

name: springai_demo1

# AI配置

ai:

# Ollama 配置

ollama:

base-url: http://localhost:11434

chat:

model: llama3.2:1b

上述配置文件中,指定 ollama 的基础地址(base-url) 为 http://localhost:11434 ,用于聊天的模型为 llama3.2:1b。

AI广告位

编写 Controller

创建 OllamaController 控制器,实现一个简单 chat 接口,如下:

package com.hxstrive.springai.springai_ollama.controller;

import jakarta.annotation.Resource;

import org.springframework.ai.ollama.OllamaChatModel;

import org.springframework.web.bind.annotation.GetMapping;

import org.springframework.web.bind.annotation.RequestMapping;

import org.springframework.web.bind.annotation.RestController;

/**

* 使用 Spring AI 调用本地 Ollama

* @author hxstrive.com

*/

@RequestMapping("/ai/ollama")

@RestController

public class OllamaController {

@Resource

private OllamaChatModel ollamaChatModel;

@GetMapping("/chat")

public String chat(String message) {

return ollamaChatModel.call(message);

}

}

上面通过 Spring 自动注入 OllamaChatModel ,然后利用它调用 Ollama,代码是不是非常简单。

运行&验证

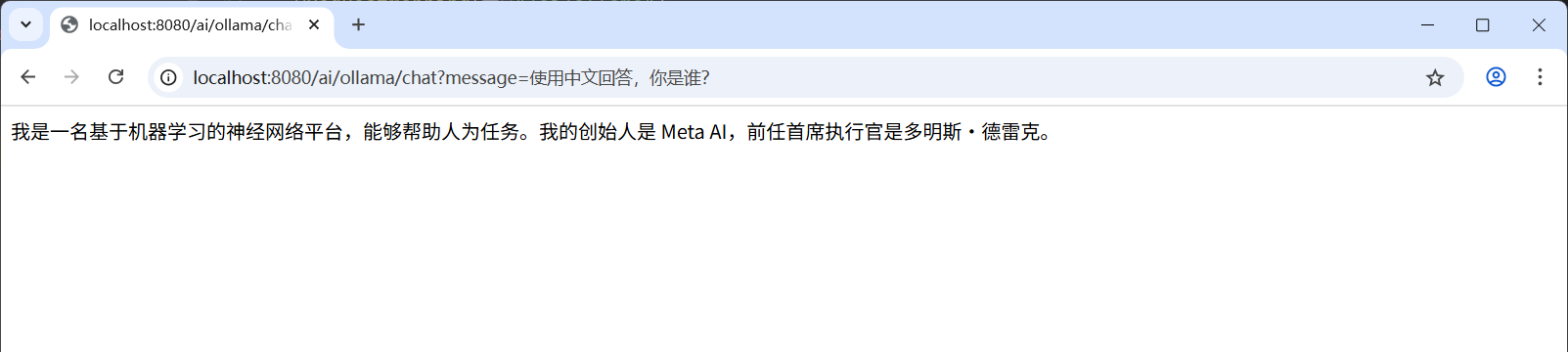

运行项目,使用浏览器访问 http://localhost:8080/ai/ollama/chat?message=使用中文回答,你是谁 地址,运行效果如下图:

到这里,简单的演示了如何使用 Spring AI 访问本地 Ollama 服务,非常简单,后续将使用单独章节详细介绍 Ollama 相关的详细信息。